Israel Pakai AI untuk Bombardir Palestina, Seberapa Bahaya? - CNN Indonesia

Israel Pakai AI untuk Bombardir Palestina, Seberapa Bahaya?

CNN Indonesia

Rabu, 22 Nov 2023 10:51 WIB

Pasukan Israel (IDF) disebut menggunakan kecerdasan buatan (AI) untuk menargetkan lokasi atau bangunan yang diserang saat melancarkan agresi di Gaza, Palestina, yang hingga saat ini telah menewaskan lebih dari 13 ribu orang, dengan lebih dari separuhnya perempuan dan anak.

Sebahaya apa penggunaan AI dalam perang?

Sebuah laporan menyebutkan bahwa Israel mulai menggunakan Ai untuk menargetkan lawan-lawan mereka di medan pertempuran di Gaza. Namun, ada kekhawatiran bahwa hal ini disalahgunakan.

ADVERTISEMENT

SCROLL TO CONTINUE WITH CONTENT

Menurut laporan Al Jazeera, Israel memiliki sebuah cabang militer bernama Sigma yang didedikasikan untuk mengembangkan dan menggunakan AI untuk serangan. Mereka bahkan menyebut perang 2021 dengan Hamas sebagai perang kecerdasan buatan pertama.

IDF menggunakan Fire Factory, sebuah perangkat lunak berbasis AI untuk memilih target di seluruh Gaza yang jumlahnya mencapai ribuan. IDF kemudian menugaskan mereka ke drone, pesawat tempur, tank, dan unit artileri. Semuanya dilakukan serentak, dalam waktu bersamaan.

"Ini secara keseluruhan lebih fleksibel dan secara keseluruhan lebih adaptif untuk menciptakan segala jenis kumpulan data atau jenis jaringan saraf tiruan daripada membeli F-35," kata Brigjen Aviad Dagan, Direktur Administrasi Transformasi Digital IDF, dalam sebuah video yang diposting Al Jazeera di X (sebelumnya Twitter).

IDF, dalam laman resminya, mengakui bahwa kecerdasan buatan merupakan kunci. Mereka mengklaim bahwa Sigma merupakan cabang IDF "untuk mengembangkan, meneliti, dan mengimplementasikan kecerdasan buatan dan penelitian perangkat lunak canggih yang terbaru agar IDF tetap mutakhir."

Letnan Kolonel Nurit Cohen yang memimpin proyek ini pada 2017 mengatakan Sigma bertujuan untuk meningkatkan efektivitas dan efisiensi IDF. Sigma mengembangkan teknologi dan mencari cara untuk memberikan dampak yang nyata.

IDF percaya AI bakal memberikan dampak yang lebih besar pada kegiatan operasional mereka. Menurutnya ada tiga tahap AI yang digunakan IDF.

"Ada AI deskriptif, di mana komputer dapat memahami konteks dan mengidentifikasi serta mengklasifikasikan data. Ada AI prediktif, di mana komputer kemudian memprediksi dampak dari data tersebut. Terakhir, ada AI perspektif, di mana komputer dapat membuat pilihan cerdas berdasarkan prediksinya. Saat ini, kami telah menguasai tahap pertama, dan sedang mengerjakan AI yang lebih canggih," kata Cohen.

IDF mengumumkan mereka telah menanamkan kecerdasan buatan ke dalam operasi-operasi yang mematikan. Seperti yang dilaporkan Bloomberg pada 15 Juli, awal tahun ini, IDF telah mulai "menggunakan kecerdasan buatan untuk memilih target serangan udara dan mengatur logistik masa perang."

Para pejabat Israel mengatakan pada saat itu bahwa IDF menggunakan sistem rekomendasi AI untuk memilih target untuk pengeboman udara, dan model lain yang kemudian akan digunakan untuk mengatur serangan berikutnya dengan cepat.

IDF menyebut sistem kedua ini sebagai Fire Factory, dan, menurut Bloomberg, sistem ini "menggunakan data tentang target yang disetujui militer untuk menghitung muatan amunisi, memprioritaskan dan menugaskan ribuan target ke pesawat terbang dan pesawat tak berawak, dan mengusulkan jadwal."

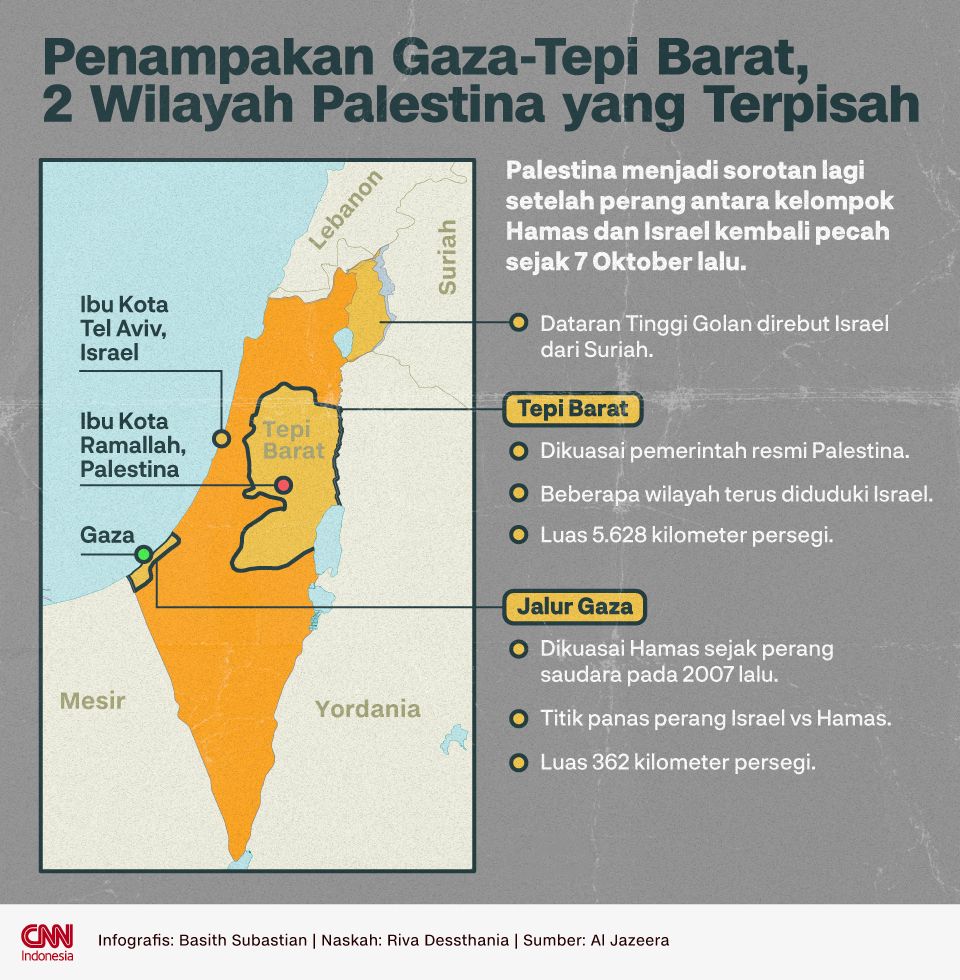

Penampakan Gaza-Tepi Barat, 2 Wilayah Palestina yang Terpisah (Foto: CNNIndonesia/Basith Subastian) Penampakan Gaza-Tepi Barat, 2 Wilayah Palestina yang Terpisah (Foto: CNNIndonesia/Basith Subastian) |

Dampak bahaya penggunaan AI di halaman berikutnya...

Page 2

CNN Indonesia

Rabu, 22 Nov 2023 10:51 WIB

Israel mengatakan keputusan akhir untuk meluncurkan serangan selalu diambil oleh manusia. Namun, ketika perang terjadi dalam skala besar, masih mungkinkah manusia melakukan pengamatan secara cermat?

"Bahkan ketika ada manusia yang meninjau keputusan AI, itu hanya membutuhkan waktu beberapa menit dan kami tidak begitu yakin seberapa banyak uji tuntas yang dilakukan orang-orang ini sebelum menyetujui keputusan yang dibuat AI," kata Anwar Mhajne, Asisten Profesor di Stonehill College Boston.

"Ada juga kekhawatiran bahwa ketergantungan pada sistem AI dapat menciptakan rasa percaya diri yang salah di mana Anda seperti, oke, jadi AI membuat keputusan ini dan mengumpulkan data, jadi saya akan segera menyetujuinya dan target tersebut dilegitimasi berdasarkan data yang dikumpulkan oleh AI," lanjutnya.

ADVERTISEMENT

SCROLL TO CONTINUE WITH CONTENT

Menurutnya, AI di militer pada dasarnya adalah algoritma Kotak Hitam, sehingga proses pengambilan keputusannya kabur dan terlalu rumit untuk dipahami oleh manusia mana pun, apalagi untuk diintervensi.

Menurut Mhajne penggunaan AI dalam serangan Israel ke Palestina ini berpeluang menghilangkan 'rasa bersalah' karena mereka tidak melihat langsung korbannya secara langsung.

"Sangat memprihatinkan bahwa kita menghilangkan unsur manusia ke manusia, karena dengan sistem AI, sangat cepat, sangat mudah. Anda tidak merasa bersalah. Anda bahkan tidak melihat korbannya. Jadi itu membuatnya terlihat seperti video game, benar. Dan itu juga menghilangkan tanggung jawab yang Anda miliki, terhadap korban sipil," kata Mhajne.

Paul Scharre, wakil presiden Center for a New American Security mengatakan bahwa sistem AI terkenal tidak dapat diandalkan dan rapuh, terutama ketika ditempatkan pada situasi yang berbeda dengan data pelatihannya.

Scharre mengaku tidak mengetahui rincian sistem spesifik yang mungkin digunakan IDF, tetapi AI dan otomatisasi yang membantu dalam siklus penargetan mungkin akan digunakan dalam skenario seperti perburuan Israel terhadap personel dan material Hamas di Gaza. Penggunaan AI di medan perang berkembang dengan cepat, katanya, tetapi membawa risiko yang signifikan.

"Setiap AI yang terlibat dalam keputusan penargetan, risiko utamanya adalah Anda menyerang target yang salah," kata Scharre, mengutip Los Angeles Times.

"Ini bisa menyebabkan korban sipil atau menyerang target yang bersahabat dan menyebabkan pembunuhan," lanjutnya.

Selain itu, sistem AI apa pun yang berusaha mengotomatiskan dan mempercepat pemilihan target meningkatkan kemungkinan kesalahan yang dibuat dalam prosesnya akan lebih sulit untuk dilihat.

Jika militer merahasiakan cara kerja sistem AI mereka, tidak ada cara untuk menilai jenis kesalahan yang mereka buat.

"Saya pikir militer harus lebih transparan dalam cara mereka menilai atau melakukan pendekatan terhadap AI," ungkap Scharre.

"Salah satu hal yang telah kita lihat dalam beberapa tahun terakhir di Libya atau Ukraina adalah zona abu-abu. Akan ada tuduhan bahwa AI digunakan, tetapi algoritme atau data pelatihannya sulit untuk diungkap, sehingga menilai apa yang dilakukan oleh militer jadi tantangan."

Bahkan dengan kesalahan yang tertanam dalam kode pembunuhan itu, AI sementara itu dapat memberikan lapisan kredibilitas pada target yang mungkin tidak dapat diterima oleh operator pangkat dan jabatan.

Israel masih terus menggempur Gaza. Sejauh ini, jumlah korban jiwa agresi di Gaza sudah mencapai 13.300 orang, dan mayoritas korban adalah anak-anak dan perempuan.

(tim/dmi)